Retour sur AWS Summit Paris 2018

Chaque année lors de l’AWS Summit Paris, clients et partenaires sont réunis pour évangéliser sur les bienfaits du Cloud public et faire le point sur l’offre AWS, qui a depuis longtemps depassé le simple cadre de l’infrastructure as a service. AWS fournit toutes les briques de l’infrastructure, mais aussi celles des bases de données, du Big Data, et du Machine learning sur lequel un focus particulier est fait cette année. Sur scène cette année, aux côtés de Werner Vogels, trois grandes entreprises françaises et un digital player : SNCF, Renault, Euronext et SquareContent.

Le jeu de Lego du Cloud AWS

Werner Vogels le répète chaque année, AWS Summit est une journée dédié à l’apprentissage, une opportunité de découvrir ce qui se fait sur le Cloud et d’apprendre de ses pairs, qui utilisent AWS pour construire et développer des services. Le Cloud AWS est un outil pour ceux qui construisent, développeurs, professionnels de la data, étudiants, ops… et Werner utilise l’analogie de la maison : « AWS ne vous propose pas une maison pré-fabriquée, mais vous fournit les briques et les outils pour construire la maison dont vous avez besoin. » Le développement sur le Cloud est différent en ce sens que par le passé, les vendeurs de logiciels vous dictaient comment construire vos applications.

Pour illustrer la différence AWS, Werner Vogels explique que 95% des services AWS ont été conçus sur la base des feedbacks des clients. Ces briques logicielles, ces « building blocks » sont de plus en plus petites pour donner plus d’agilité et de connectivité (on premise, cloud, open source, etc.) aux infrastructures. Exemple, l’architecture utilisée par IRobot (Roomba, robot aspirateur autonome) entièrement serverless, est basée sur API Gateway, Lambda, AWS IoT, SQS, Cloudwatch. Elle n’utilise aucun server, et fait appel à des blocs connectés par le Serverless. Selon Werner Vogels, c’est l’exemple parfait de l’architecture du 21ème siècle.

Le Cloud pour les développeurs

Si le Cloud AWS a longtemps été associé à l’infrastructure as a service, il vise également aujourd’hui à attirer en large nombre les développeurs, et à leur proposer un IDE (environnement de développement) et des outils de CI/CD. Il n’y a pas de bonne plateforme de développement sans un bon IDE, et Cloud9 intègre les outils essentiels pour des langages comme JavaScript, Python, PHP et d’autres. Cloud9 permet surtout de développer et tester des fonctions Lambdas dans l’IDE. Côté CI/CD, AWS propose la suite Code Deploy, Code Commit, et Code Build pour les pipelines. Petit à petit, AWS occupe tous les terrains, avec une offre très large qui dépasse largement le cadre de l’infrastructure as a service. En 2009, le Cloud AWS se limitait au calcul et aux bases de données, aujourd’hui le focus sur le Machine learning, le deep learning, l’IoT, le Big Data…

Cas client : SNCF

Quel meilleur ambassadeur pour AWS que la SNCF, archétype de la grande entreprise française ? Faire monter sur scène Raphaël Viard, CTO de la SNCF, c’est tout un symbole, et un appel à ces entreprises françaises traditionnelles qui n’ont pas encore franchi le cap du Cloud. Le site Voyage SNCF, lancé en 2000, a longtemps été le premier site de e-commerce en Europe; la SNCF a ensuite lancé IDTGV, marque 100% web, une application mobile Voyage SNCF, et un assistant de mobilité en 2015. En 2015, la transformation numérique déjà faite auprès des clients est amenée en interne, avec l’arrivée de la maintenance prédictive et le lancement d’une transformation majeure des systèmes d’information. D’ici 2020, la SNCF va migrer 60% de son parc applicatif vers le Cloud.

Le patrimoine informatique de la SCNF est complexe, à la hauteur du réseau géré (30 000km de voies, 15 000 trains, 25 000 bus, 3000 gares, 2 datacenters et 1425 applications !). L’application SNCF, qui agrège des données internes et externes, en temps réel avec l’exploitation des trains, supporte 40 millions de connexions par mois, ce qui en fait une application très éligible au cloud bien que critique. Cette application doit en effet absorber des pics de charge (épisodes neigeux, grèves, blackout à Saint-Lazare…), et peut ainsi passer de 170 à 240 instances en 20 minutes grâce à la scalabilité du Cloud. Le passage sur le Cloud doit aussi répondre à des enjeux de résilience. En début d’année, suite à un incident de production, la SNCF a déclenché un plan de reprise d’activité sur le Cloud. La SNCF est désormais entrée dans une approche Cloud first, et notamment pour 144 applications critiques pour les trains. A ce sujet, voir également l’article sur la démarche Chaos Engineering menée chez OUI.sncf

Machine learning

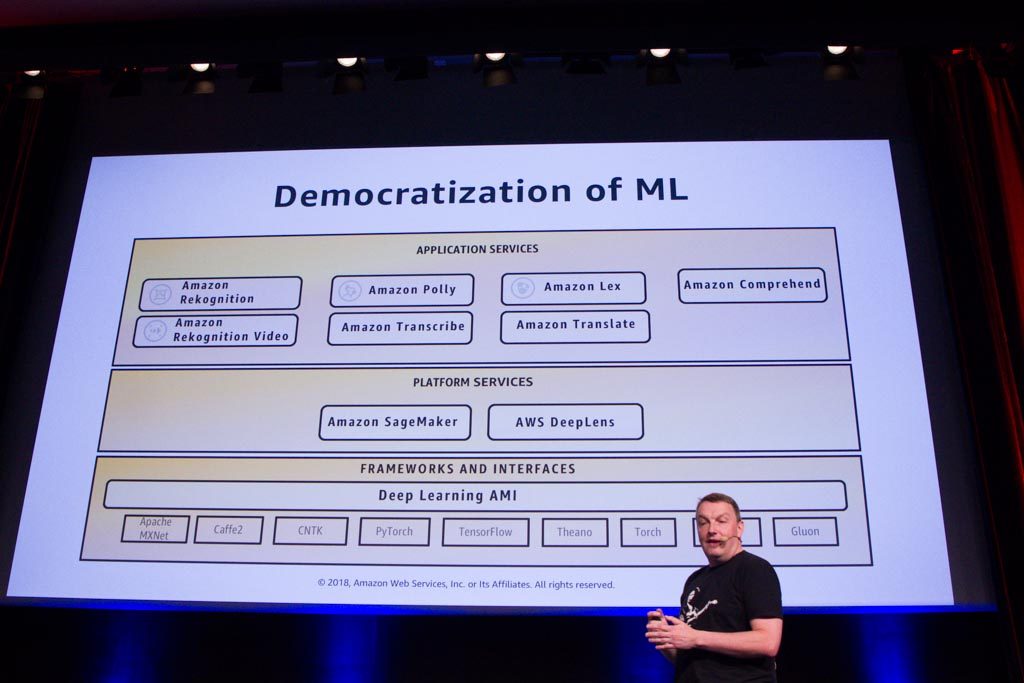

Il est sur l’agenda de 65% des CTO : le machine learning est le sujet du moment. Werner Vogels, CTO Amazon est bien placé pour rappeler que le site e-commerce fait du machine learning depuis près de 25 ans. Quels sont les challenges du machine learning en 2018 ? Il faut passer à du machine learning en temps réel selon Werner Vogels, et pouvoir exploiter les données d’hier et d’aujourd’hui pour prédire ce qui va se passer demain. Le seul obstacle à la démocratisation du machine learning, c’est le manque de data scientists disponibles sur le marché et AWS ambitionne de proposer de services aux entreprises qui n’ont pas les data scientists pour développeur leur machine learning. AWS propose ainsi une stack complète pour le machine learning, avec les frameworks les plus connus sur le marché (Caffe2, CNTK, Pytorch, TensorFlow, Keras, Gluon), et Amazon Sagemaker comme plateforme centrale. Autour de ce socle, AWS a ajouté un certain nombre de services :

- Rekognition (image et video)

- Polly (text to speech)

- Transcribe (speech to text, support du 16KHz et 8Khz)

- Translate (12 correspondances de langages)

- Comprehend (analyse des sentiments, entités, langues, sujets, chiffres dans un texte)

- Lex (apps de conversation)

Les bases de données

Egalement au coeur de l’offre AWS, les bases de données, et la migration des bases on premise vers le Cloud. AWS annonce ainsi avoir migré plus de 75 000 bases sans downtime avec Database Migration Service, qui a été lancé il y a deux ans. Aurora, la base de données compatible MySQL et PostgreSQL, qui assure haute disponibilité et durabilité, est toujours le service AWS à la plus forte croissance (c’était déjà le cas en 2017). Un mode multi master est d’ailleurs disponible en preview, pour scaler sur plusieurs datacenter, et devrait permettre le multi régions en 2018. Aurora est la première base relationnelle à proposer un scale out sur plusieurs datacenters. Une version serverless d’Aurora existe également, pour les applications avec des charges cycliques ou imprévisibles.

Cas client : Contentsquare

Contentsquare se définit comme une « digital experience insights platform », c’est-à-dire une plateforme SAAS d’analyse du comportement des clients sur les sites internet : heatmap, session replay, insights. Lucie Buisson, VP Produit, explique avoir beaucoup investi dans la data vizualisation, afin de permettre à ses clients de mettre en place une organisation basée sur la data. Contentsquare collecte toutes les interactions du client sur un site, sur l’ensemble des devices. Cette collecte exhaustive doit assurer la rétroactivité et la rapidité d’accès à la donnée a posteriori, et donc Contentsquare a connu une très forte croissance du volume d’interactions collectées. Travailler avec AWS a permis un focus sur le métier et la création de valeur pour les clients sans se soucier de l’administration de bases. Au coeur du système, on trouve S3, associé à Kafka et ElasticSearch, et EMR pour l’intelligence et la modélisation des données. S3 travaille également en complément avec Redshift, omme laboratoire d’exploration des data.

Cas client : Euronext

Principale place boursière de la zone euro, Euronext est une société vieille de 400 ans, dont la plateforme traite des millions de transactions par jour. La durée de traitement d’un ordre est quelques dizaines de millisecondes, et 1,5 milliards de messages sont stockés chaque jour. Comme Nicolas Rivay, Chief innovation officer, le précise, l’intégrité des données est très important, et chaque message doit être disponible en permanence. Euronext a lancé il y a deux ans une réflexion sur l’exploitation des données et l’IA, pour répondre aux enjeux de performance de la bourse. Les traitements se faisaient à la clôture de la bourse, et prenaient en moyenne 6 heures (12h suite au vote du Brexit le 24 juin 2016).

L’infrastructure étant en fin de vie, le régulateur européen étant plus exigeant sur la qualité du stockage et l’intégrité des données, Euronext a lancé la refonte de son infrastructure début 2017. A ce moment, le scénario Cloud n’était pas privilégié. C’est pourtant le Cloud qui a été choisi, entre autres pour des raisons de compliance GDPR, de coût total de possession inférieur aux autres scénarios, et de l’accès à un catalogue de services et d’innovation très complet. La solution retenue est une architecture hybride avec une certaine partie de l’infrastructure en datacenter, et un ensemble de briques Cloud et services managés : EMR, S3, Glacier, Redshift, Athena, Kafka, SQL Server, talend, Optiq. 45 jours étaient nécessaires auparavant pour fournir une console analytics aux data scientists, une seule journée suffit maintenant. La semaine prochaine, Euronext lancera la migration de sa plateforme de trading pour passer d’une analyse j+1 à du quasi temps réel, essentiel pour la compréhension du marché. C’est une première étape d’une approche Cloud first, puisque dorénavant chaque application sera en priorité sur le cloud, avec 100% d’infrastructure as code.

Best practices AWS

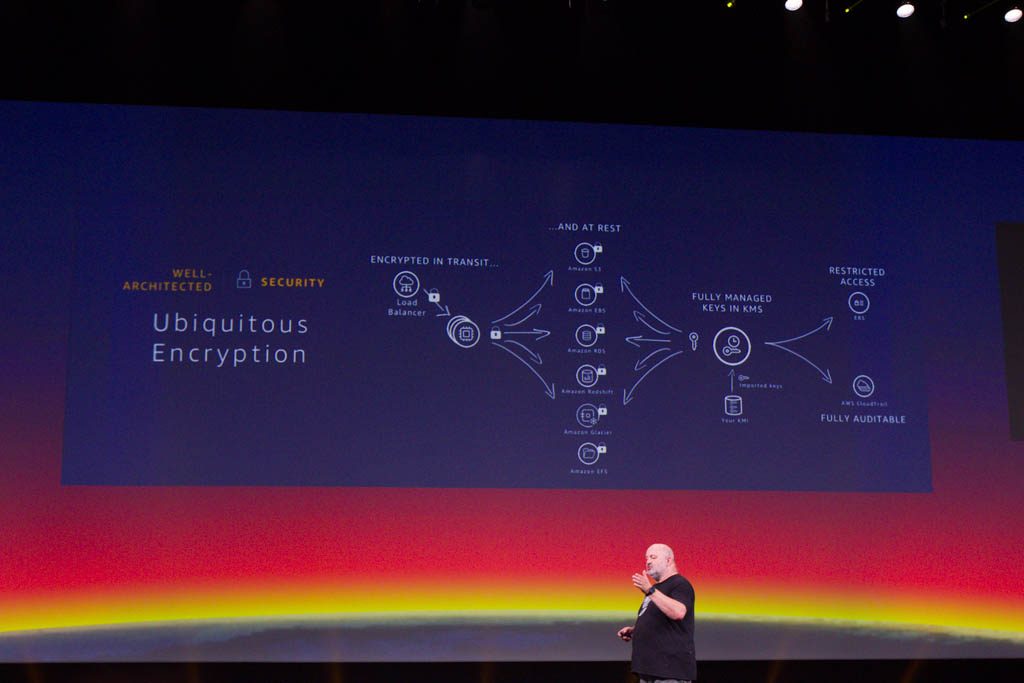

Ce summit est également l’occasion pour Werner Vogels de revenir sur les best practices AWS et notamment sur le concept de « well architected framework », qui s’appuie sur :

- excellence ops

- securité et compliance

- fiabilité

- performance

- optimisation des coûts

Werner Vogel continue ensuite sur la question de la sécurité et des pratiques à mettre en place : s’appuyer sur la notion d’identité, permettre la traçabilité, appliquer la sécurité sur toutes les couches, automatiser les best practices sécurité, encrypter la donnée en transit et au repos (notamment avec KMS), s’appuyer sur les services et l’automatisation. Et de lister tous les services AWS autour de la sécurité : Trusted Advisor, AWS Config, Amazon Inspector, AWS Secrets Manager (gestion des secrets et leur cycle de vie, paiement à l’suage), Cloudwatch, Cloudtrail, Macie, GuardDuty, Certificate Manager, etc. Werner Vogels insiste : on devrait tous être responsable de la sécurité, la sécurité est le travail de chacun, il n’y a plus aucune raison de ne pas encrypter les données.

Cas client : Renault

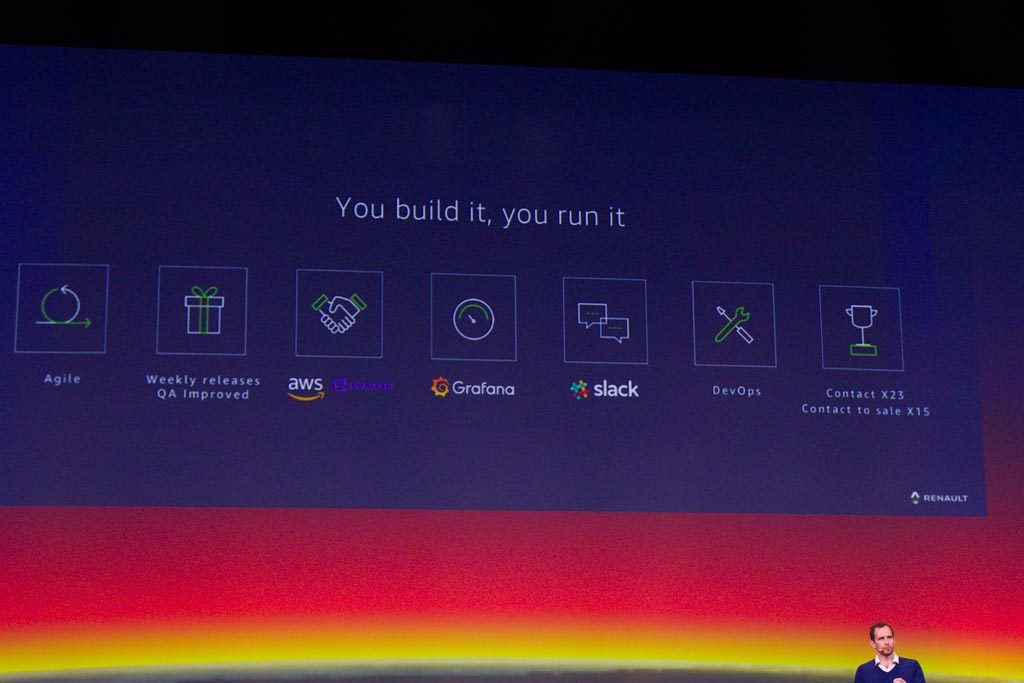

La SNCF, et maintenant Renault, autre entreprise française historique et symbolique, voilà de quoi convaincre les indécis du Cloud. C’est Pierre Houlès, VP Sales & Marketing information systems, qui témoigne de la transformation digitale de Renault à l’aide du Cloud (lire également notre article sur Renault Digital). Aujourd’hui il existe de plus en plus de services autour de la mobilité, il y a de moins en moins de gens propriétaires de leur véhicule et quand ils le sont, ils l’ont acheté sur des sites d’occasion. Pour répondre à ces défis, Renault a donc entamé un programme de transformation et déroule un business model axé sur le service et la technologie.

Le premier périmètre de transformation concerne le digital, sales et aftersales, et implique les sites web, la gestion du réseau, les outils de réparation, la gestion des pièces, le CRM, les documentations de réparation, etc. ECS (containers), Lambda, et RDS sont les services AWS les plus utilisés par Renault (et en vrac : Cloudfront, Cloudwatch, KMS, S3, SNS, VPC, etc.). Ce socle a été mis à disposition de l’ensemble des développeurs, et chaque équipe est en charge de son périmètre suivant la philosophie « You build it, you run it« . En complément, Datadog et Grafana sont utilisés pour monitorer les indicateurs business et IT. La première mise en production a été celle du site web grand public des véhicules d’occasion du marché français, et le taux de transformation a été multiplié par 15. Prochain défi, les véhicules connectés et le traitement des volumes de données qu’ils génèrent.

Machine Learning

La session dédiée au machine learning, animée par Julien Simon, propose un tour d’horizon des services d’IA et de Machine Learning disponibles sur AWS: services applications (Amazon Rekognition, Amazon Polly, etc), services plates-formes (Amazon SageMaker) et services infrastructure (Deep Learning AMI, instances GPU, etc.). Comme l’explique Julien Simon, Amazon fait du machine learning depuis les débuts de l’entreprise : systèmes de recommandation, robots autonomes, tests de livraisons automatisée par drone, et plus récemment Alexa ou l’épicerie Amazon Go, où le checkout se fait automatiquement grâce à des caméras qui analysent le contenu du panier.

Le positionnement d’AWS sur le sujet est de fournir des services de machine learning qui soient opérables sans être un expert du sujet. Selon Julien Simon, c’est sur AWS que sont opérés le plus grand nombre de produits et de services de machine learning, avec des dizaines de milliers de clients. Olivier Marc, de la société Advalo, explique ainsi comment le machine learning permet de passer du marketing de masse au marketing personnalisé. Les opérations marketing génèrent moins de 1% de réponse, les intentionnistes ne sont pas bien traités et il y a une inefficacité à transformer les leads, d’où le besoin d’un marketing qui sait intervenir au bon moment.

A défaut de pouvoir mettre derrière chaque client un commercial, le machine learning permet de répondre à ces nouveaux enjeux. La plateforme SaaS d’Advalo sur AWS traite ainsi 5 milliards de données par jour avec Amazon EMR et Apache Spark. Le Cloud a permis à la startup de variabiliser des coûts. Elle utilise actuellement 250 sources de données et 150 modèles prédictifs : le deep learning permet par exemple d’identifier les styles vestimentaires d’un consommateur à un autre en analysant les caractéristiques communes des images produits. Ensuite, le moteur propose des recommandations. Selon Olivier Marc, seulement 5% des communications individualisées mais représentent 60% de l’engagement client.

On entre ensuite dans le vif du sujet avec la présentation des services de haut niveau, tous basés sur du machine learning ou du deep learning. Ces services sont accessibles sur API, sans nécessiter de connaissance sur le machine learning. Rekognition est un service d’analyse d’image (et de videos), qui fait de la détection de visage, de paysage et d’objets. En sortie, on récupère un document json qui est une liste de labels avec score de confiance (une ville, centre ville, en soirée, dock, port, etc.). Concernant l’analyse de visages, Rekognition est capable de trouver leur position dans l’image, et leur affecter un certain nombre d’attributs (sexe, tranche d’age, emotion, lunettes, barbe, etc.). Le service fonctionne sur un ou plusieurs visages. Jusqu’à 100 visages sont détectables, en temps réel.

Il est aussi possible de comparer des visages, ou de rechercher des visages dans des collections. Parmi les applications possibles, la modération de contenu automatisée, ou la détection de texte dans les images (extraction de texte sur des documents structurés). Rekognition Video étend ces fonctionnalités à la vidéo, et y ajoute une dimension temporelle pour détecter l’activité (est ce que le personnage court ou tombe ?). Sky News a utilisé Rekognition Video lors du récent mariage royal pour identifier toutes les célébrités au moment de leur entrée dans l’église, en temps réel, et pour afficher des éléments de contexte et d’information.

Polly, application de text to speech (25 langues, 53 voix, en temps réel), permet de générer du contenu parlé à partir d’une chaîne de caractères. La démo qui suit nous permet de découvrir Lea, nouvelle voix française de Polly. On apprend au passage qu’on peut enrichir Polly avec un langage de balisage de synthèse vocale (SSML), pour changer l’intonation, la vitesse, créer des effets d’emphase, et rendre la voix plus naturelle. Une fonction de respiration a également été ajoutée, et celle-ci est modulable (pour marquer une pause, simuler l’essouflemment, etc.).

Translate, comme son nom l’indique, est un service de traduction en temps réel, également accessible via API, qui reconnaît automatiquement le langage source, et offre à ce jour 12 paires de langages.

Transcribe est un service de speech to text, qui permet de générer un fichier texte depuis depuis un fichier son, mais pas en temps réel. Transcribe reconnaît le texte, la ponctuation, détecte les différents interlocuteurs et ajoute des timestamps. Il supporte des fichiers de bonne ou de mauvaise qualité audio, y compris la qualité téléphonique, le principal cas d’usage concernent les call center.

Enfin, Comprehend traite le langage naturel, pour extraire depuis un document les entités, personnes, lieux, noms de produits, organisations, phrases clés, etc. Comprehend détecte 100 langages, et peut analyser les sentiments (positif, négatif, neutre). Il permet aussi le topic modeling, ou la construction de groupes de documents à partir d’une collection de documents. Le Washington Post l’utilise pour créer des groupes de sujets sur ses articles (stock market, US sports, etc.).

La démo qui suit fait appel à tous ces services. Julien Simon souhaite développer un service capable de lire des panneaux , détecter le texte, la langue, le traduire dans différentes langues et le lire. 25 lignes de code Python suffisent pour appeler Rekognition, Comprehend, Polly puis Translate et fournir le résultat escompté, la lecture du texte à l’image en 5 langues différentes. Applaudissements mérités, parvenir à ce résultat il y a encore 3 ans aurait mobilisé d’énormes ressources. Le coût de cette démo est de quelques fractions de cents.

En descendant plus bas dans les couches, AWS propose aussi des services plateforme pour entraîner ses propres modèles et travailler avec ses datasets pour des besoins plus spécifiques. Néanmoins il reste fastidieux de nettoyer les données, et de monter l’infrastructure pour entraîner son IA. Sagemaker est donc conçu pour permettre aux développeurs de construire et d’entraîner leurs modèles rapidement, et de déployer à l’échelle sans avoir à gérer de serveurs. Bref, de se concentrer sur l’essentiel : la sélection de l’algorithme, la sélection des paramètres et la préparation des données.

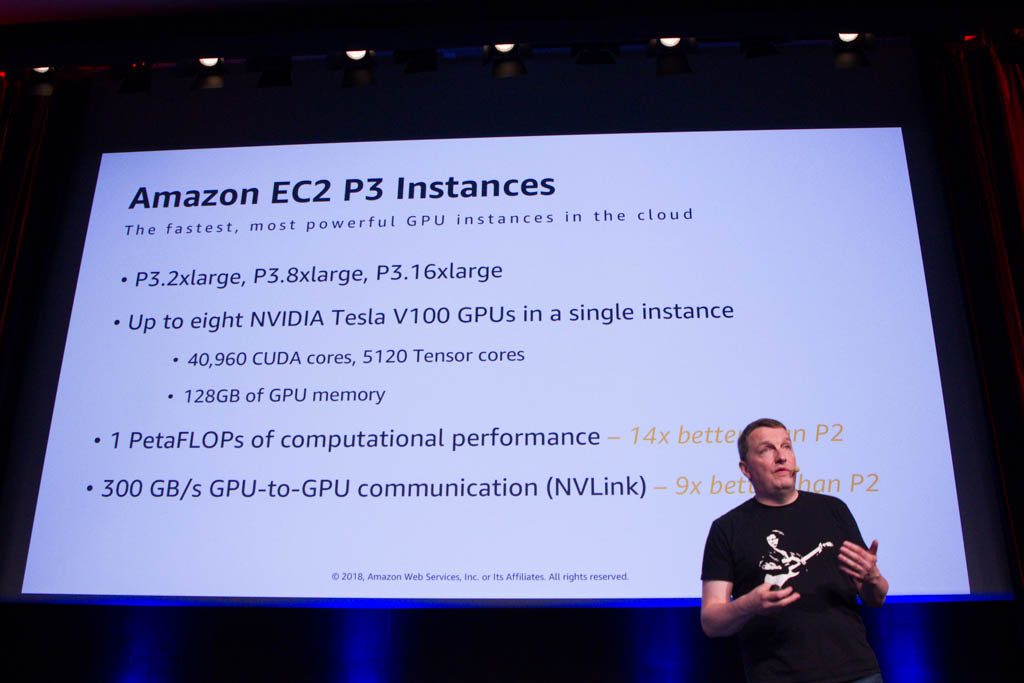

Cette session se termine par l’évocation des instance dédiées au machine learning, pour ceux qui veulent construire leur propre solution : les instances C5 (compute de 5ème génération, processeurs de dernière génération, architecture Intel Skylake), et P3 (Nvidia V100) … 1 petaflop dans une seule instance AWS !